#77 Transformation numérique en 2022

Subscribe to get the latest

on 2022-02-17 00:00:00 +0000

with Darren W Pulsipher, Gretchen Stewart, Anna Scott,

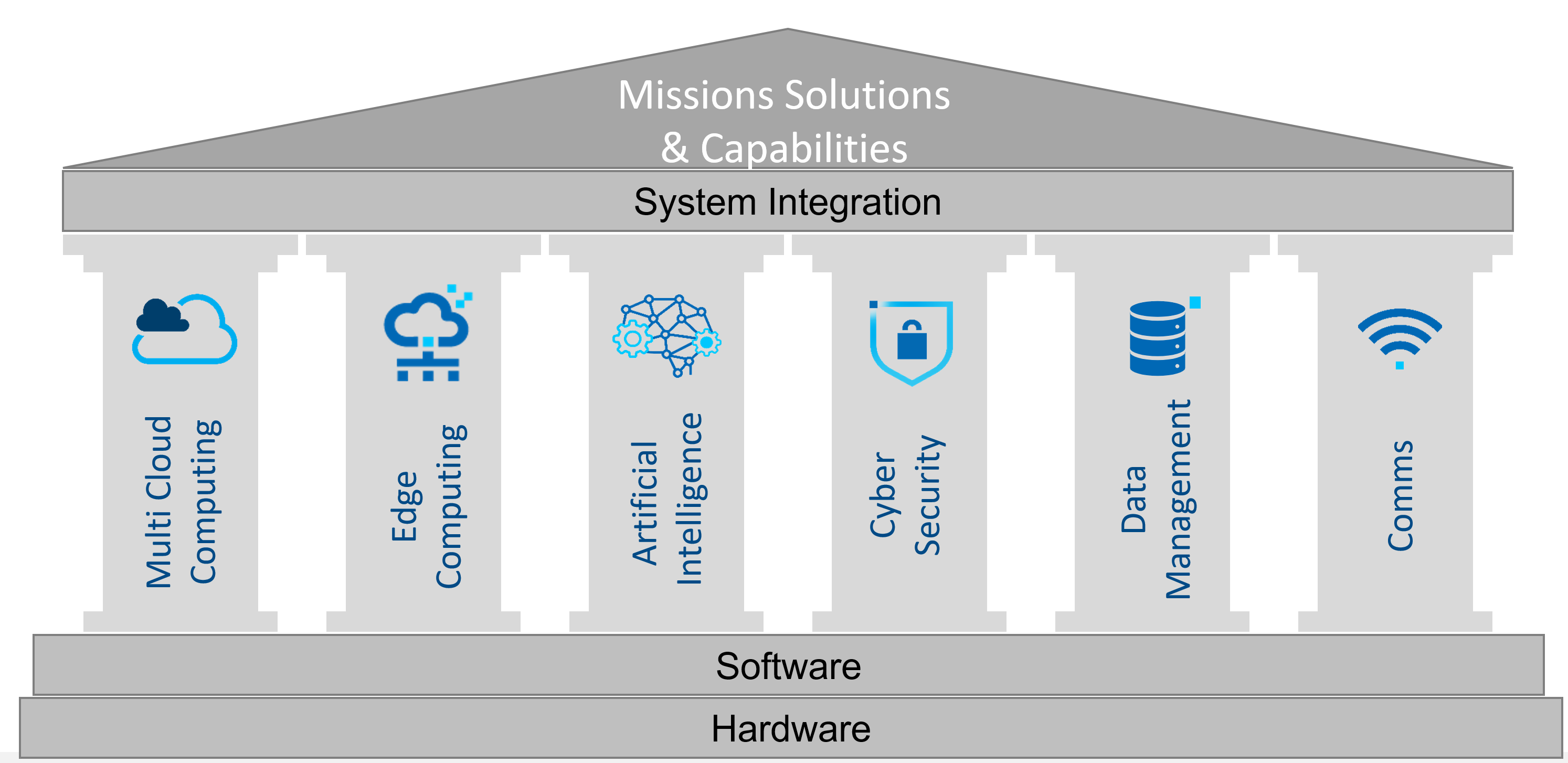

Intelligence d'Intel's Darren Pulsipher, Architecte Principale des Solutions, Dr. Anna Scott, Architecte Principale des Limites et Gretchen Stewart, Scientifique Principale des Données discutent des six piliers de la transformation numérique en 2022 : l'informatique multi-cloud, l'informatique en périphérie, l'intelligence artificielle, l'apprentissage automatique, la cybersécurité, la gestion des données et les communications.

Keywords

#employeeengagement #5g #zerotrust #microservices #multicloud

En tant que chef du service des données pour le secteur public d’Intel, Gretchen passe ses journées à discuter avec les clients de leurs défis liés aux données, de la gestion des données, de la gouvernance des données, de l’éthique concernant ce qu’ils font et de l’intelligence artificielle responsable.

Les six années d’Anna chez Intel ont été axées sur l’IoT et les technologies de pointe, avec les trois dernières années passées dans le secteur public. Les deux s’accordent à dire que 2022 sera une année passionnante, remplie de possibilités révolutionnaires.

Darren, Gretchen et Anna représentent chacun différentes parties de la transformation numérique avec les clients, mais se sont réunis pour fournir une manière commune de parler du sujet, avec six piliers de la transformation numérique : le calcul multi-cloud, le calcul périphérique, l’intelligence artificielle, l’apprentissage automatique, la cybersécurité, la gestion des données et les communications. Ils sont d’accord pour dire que ce seront les domaines des grandes transformations dans l’année à venir. Intel est profondément impliqué dans chacun d’entre eux, car ils ont développé le matériel et le logiciel pour soutenir chacun des piliers. Les piliers sont interconnectés et Intel joue un rôle clé dans l’avancement de l’industrie.

Le matériel d’Intel constitue la base de la plupart des fournisseurs de cloud. Du point de vue logiciel, Intel a optimisé les cadres communs que les gens utilisent pour l’IA, le ML ou l’apprentissage approfondi afin de tirer le meilleur parti du matériel sous-jacent. Dans certains cas, les performances sont dix à cent fois meilleures grâce au logiciel d’Intel.

Non seulement Intel a fourni du matériel pour les réseaux périphériques et de communication, en particulier dans le domaine de la 5G, mais il a également enrichi ces domaines d’activité avec des architectures logicielles de référence. De plus, Intel s’efforce de faire fonctionner les écosystèmes pour tout le monde. Il se concentre fortement sur les systèmes ouverts d’une manière non propriétaire, ce qui facilite l’entrée de nouveaux acteurs et permet aux acteurs existants de se développer davantage sur ces nouveaux marchés et d’offrir des avancées passionnantes. Intel est l’un, voire peut-être le principal, contributeur à la communauté du logiciel open-source.

Pilier de la cybersécurité

Implicites dans les conceptions matérielles d’Intel se trouvent des fonctionnalités de sécurité et des capacités permettant aux clients de l’écosystème de protéger leurs données dans toutes leurs différentes permutations.

La sécurité n’est jamais statique ; elle évolue constamment. Intel seul ne va pas résoudre les problèmes de sécurité d’une organisation. La sécurité est une interaction entre ce que vous faites avec votre matériel, comment vous intégrez les bons éléments logiciels et les limites et politiques de votre organisation.

Intel se concentre sur plusieurs domaines, mais un rôle fondamental est assuré par la sécurité matérielle et l’authentification. De nombreuses fonctionnalités peuvent être intégrées directement pour y parvenir. Une étape supplémentaire consiste à mettre en place des chaînes d’approvisionnement fiables ou transparentes que Intel peut partager avec ses clients, instaurant ainsi un haut degré de confiance. Ces capacités s’améliorent constamment et Intel travaille sans cesse à progresser.

Les cyberattaques préoccupent de nombreux clients en raison des récents incidents. Intel dispose de mesures de sécurité telles que l’exécution de confiance et les enclaves sécurisées. Ils possèdent un ensemble complet de capacités pour le type de sécurité que vous souhaitez, telles que le chiffrement, sans subir de perte importante de performance. Il existe une matrice complète de capacités, incluant un ensemble de besoins différents en périphérie en raison de la perte de la sécurité physique du centre de données.

Les architectures basées sur la confiance zéro deviennent les cadres qui sont particulièrement répandus dans le secteur public. Pour le Département de la Défense, la confiance zéro est une exigence. Intel possède de nombreuses capacités qui contribuent à cette approche.

Une taille unique ne convient pas à tous en matière de sécurité, mais il est clair que la sécurité ajoutée est une pratique du passé. La sécurité doit être intégrée dès le début et doit être constamment itérée. Les organisations doivent constamment se demander si elles ont les bons protocoles en place, si elles disposent des bons outils de détection des menaces et si elles peuvent faire confiance à toute la chaîne d’approvisionnement. Tout cela est essentiel.

Pilier de l’informatique de bord

Maintenant qu’il y a tant de choses qui peuvent être faites avec l’IA, l’apprentissage automatique et différents algorithmes, il est excitant de voir comment nous pouvons exploiter ces éléments sur le terrain et optimiser les architectures pour répondre à ces cas d’utilisation.

Il existe certains modèles vraiment simples où tout vit dans le cloud et seule la collecte des données est effectuée en périphérie. Si la connectivité le permet, les latences peuvent correspondre aux applications. Le gros du traitement peut être centré sur le cloud. Cependant, il existe d’innombrables cas d’utilisation où cela n’a aucun sens en raison de la sensibilité des données ou des exigences de latence. Ainsi, il y a des conversations intéressantes sur la façon de déterminer les architectures optimales pour la périphérie et ce qui se passe avec le cloud et le réseau.

Par exemple, pourrions-nous avoir une architecture transparente de collecte, d’utilisation et de traitement immédiat des données pour fournir des informations ? Pouvons-nous l’incorporer dans la prochaine série de formations afin que le modèle soit continuellement mis à jour ? À quelle vitesse pouvons-nous effectuer cette boucle ? Est-ce réalisable ? Avons-nous besoin de toute notre formation sur le cloud ? Si toute la formation est sur le cloud, quel est l’intervalle approprié pour redescendre ces modèles mis à jour ? Et est-ce que l’edge peut être suffisamment léger pour utiliser les éléments générés sur le cloud ? L’edge reste très complexe, et il y a de nombreuses possibilités et questions fascinantes.

Pilier de l’intelligence artificielle

l’IA (intelligence artificielle) et l’apprentissage automatique permettent à l’edge (ou à la périphérie) de faire bien plus que ce que quiconque avait précédemment envisagé. Un produit unique n’est pas toujours la réponse appropriée : il s’agit de trouver la solution adaptée à chaque situation. L’utilisation du code source ouvert est essentielle et permet de bénéficier des microservices pour exécuter des algorithmes en périphérie.

Par exemple, si vous avez des algorithmes directement à la source pour effectuer le travail de lecture, vous parlez de flux de trafic. Le rythme des feux rouges, jaunes et verts peut changer en temps réel en fonction du nombre de voitures qui passent, tout en collectant des données à renvoyer à un centre de données plus important qui pourrait ensuite effectuer un nouvel apprentissage. À la fin de la semaine, il peut donc être judicieux d’ajouter quelques microservices supplémentaires ou d’ajuster les algorithmes. Ensuite, ce conteneur retourne à la source et vous pouvez mieux réagir et continuer à apprendre.

Aussi, lorsqu’on parle de l’adéquation à l’usage, la bande passante, la latence et le format sont tous des éléments à prendre en compte.

Les rendements des cultures sont un bon exemple. Un client collecte des données qui sont envoyées vers un centre de données. Ils travaillent sur les modèles, mais cela ne se traduit pas par leur permettre de savoir qu’ils ont besoin de plus d’engrais ou qu’il existe des défis actuels liés au soleil et à la pluie. Cela signifie que la formule doit être modifiée. Vous avez besoin des données sur les rendements des cultures, des informations, de l’algorithme et des microservices dans un format beaucoup plus petit. La latence et la bande passante sont différentes, mais vous pouvez avoir une petite unité au milieu d’un champ qui collecte ces données et y répond, par exemple, au flux d’eau ou aux besoins en engrais pour améliorer les rendements des cultures.

Espérons que cette année, davantage de conceptions périphériques deviendront standardisées. Avec FlexRAM et la 5G, il existe des normes, mais tout le reste relève du Far West. De nombreuses personnes conçoivent des choses intéressantes, mais elles ne les conçoivent pas de manière à rendre facile l’utilisation de ces microservices dans un conteneur ainsi que des algorithmes d’apprentissage automatique (ML) et d’intelligence artificielle (AI). Dans certains cas, il est nécessaire d’utiliser plusieurs algorithmes pondérés de manière différente, qui changent chaque semaine en fonction de nouvelles données et d’un nouvel entraînement. Nous devons être en mesure de le faire d’une manière qui n’importe pas qui a construit un appareil. La création de normes non seulement dans les données d’IA et de ML, mais également au niveau périphérique, aidera à développer les capacités.

Pilier de communication

Le côté commercial de la 5G ouvrira la voie avec la 5G sur les téléphones partout. Cependant, il y a toujours un décalage pour disposer du type d’équipement utilisateur nécessaire pour faire différentes applications pour la périphérie ou l’entreprise, par exemple. Intel met en place ses premiers réseaux 5G avec des partenaires plus avant-gardistes et moins orientés vers le commerce. Bien que leurs partenaires commerciaux utilisent ces réseaux depuis longtemps, les réseaux privés contrôlés à des fins spécifiques sont en train d’être libérés et des applications sont en cours de développement. 2022 est l’année où ces choses deviendront réalité.

Pilier de gestion des données

Les données qui prenaient autrefois des heures voire des jours pour être ingestées, préparées, analysées et utilisées peuvent aujourd’hui être traitées en quelques minutes voire en nanosecondes. Vous pouvez également exploiter différents modèles, et lorsque les poids changent, vous pouvez agir rapidement et consulter les données afin de fournir de meilleurs services. Le déplacement des données, la gestion de ces données et l’opérationnalisation de votre IA et votre ML font partie de ce que la gestion des données apporte au monde.

Pilier Multi-Cloud

Le pilier du multi-cloud ne fait pas référence aux fournisseurs de services cloud dans ce contexte. Il fait référence à l’infrastructure en général et à la façon d’abstraire cette infrastructure pour déployer de nouvelles fonctionnalités à travers le réseau, à travers un fournisseur de services cloud, voire à travers votre propre infrastructure de centres de données. L’objectif de l’architecture multi-cloud est que vous connaissiez les utilisateurs clés et, plus important encore, comment les données sont gérées.

Différents clouds ont des capacités différentes et selon les cas d’utilisation, peuvent utiliser différents clouds à des fins différentes. Intel dispose d’architectes de solutions cloud qui aident les clients à optimiser les charges de travail parmi les offres cloud.

Tous ces piliers sont entrelacés et travaillent ensemble. Recherchez les épisodes à venir où Darren, Gretchen et Anna poursuivent cette conversation.