#185 Histoire des Applications Centrées sur les Données (révisité)

Subscribe to get the latest

on 2024-02-08 08:00:00 +0000

with Darren W Pulsipher,

Le premier épisode de ce podcast a été diffusé il y a 185 épisodes. Dans cet épisode, l'animateur Darren Pulsipher refait l'épisode un pour fournir des informations mises à jour sur l'histoire du développement d'applications centrées sur les données. Il discute de la manière dont les nouvelles technologies comme l'informatique en périphérie et l'IA ont impacté la génération de données et la nécessité d'une meilleure gestion des données.

Keywords

#virtualization #cloudcomputing #datalineage #datamanagement #cybersecurity #zerotrust #multicloud

Traitement Précoce des Données

Dans les premiers jours de l’informatique, des applications étaient construites pour transformer les données d’une forme à une autre sortie précieuse. Les premiers ordinateurs comme l’ENIAC et la machine de Turing pour casser le code Enigma fonctionnaient en prenant des données, les traitant via une application, et les envoyant vers un stockage. Au fil du temps, la technologie a évolué du matériel spécialisé à des systèmes plus généralisés avec des CPU et des capacités de mise en réseau. Cela a permis le partage de données entre les systèmes, permettant de nouvelles applications.

Émergence de la Virtualisation

Dans les années 1990 et 2000, la technologie de virtualisation a permis d’encapsuler des systèmes entiers dans des machines virtuelles. Cela a dissocié l’application du matériel, augmentant la portabilité. Avec l’émergence de Linux, les machines virtuelles pouvaient désormais fonctionner sur les processeurs x86 grand public, réduisant les coûts et les barrières à l’entrée. La virtualisation a augmenté la facilité d’utilisation mais a introduit de nouvelles préoccupations en matière de sécurité et de performance.

L’essor de l’informatique en nuage

L’informatique en nuage repose sur la virtualisation, fournissant un accès facile et sur demande aux ressources informatiques via internet. Cela a permis aux organisations de réduire les dépenses en capital et les coûts opérationnels. Cependant, le passage au cloud signifiait des défis en matière de sécurité, de performance et d’intégration. Le modèle de paiement à l’utilisation du cloud a permis de nouveaux cas d’utilisation et a rendu la consommation de ressources technologiques plus facile dans l’ensemble.

Conteneurisation et Nouvelle Complexité

La conteneurisation a davantage abstrait les applications de l’infrastructure en emballant les applications avec leurs temps d’exécution, leur configuration et leurs dépendances - cela a augmenté la portabilité et la complexité de la gestion des applications et des données distribuées à travers les différents environnements. La localité des données est devenue une préoccupation clé, contredisant les hypothèses selon lesquelles les données sont disponibles partout. Cette évolution a entraîné des implications de sécurité significatives.

Recentrage sur les données

Pour répondre à ces défis, de nouvelles architectures comme les maillages de données et la gestion de l’information distribuée se concentrent sur la localité des données, la gouvernance, la gestion du cycle de vie et l’orchestration. Les données doivent être contextualisées à travers les applications, l’infrastructure et les utilisateurs pour offrir de la valeur commerciale en toute sécurité. Des technologies comme l’IA entraînent une croissance exponentielle des données dans les environnements de bordure. Des capacités de gestion des données plus robustes sont essentielles pour surmonter la complexité et le risque.

Préoccupations de Sécurité avec la Distribution des Données

La distribution des données et des applications à travers des environnements de bord a considérablement augmenté la surface d’attaque. Les principes de zéro confiance sont appliqués pour améliorer la sécurité, avec un accent sur l’identité et les contrôles d’accès ainsi que la détection, le cryptage et les racines matérielles de la foi.

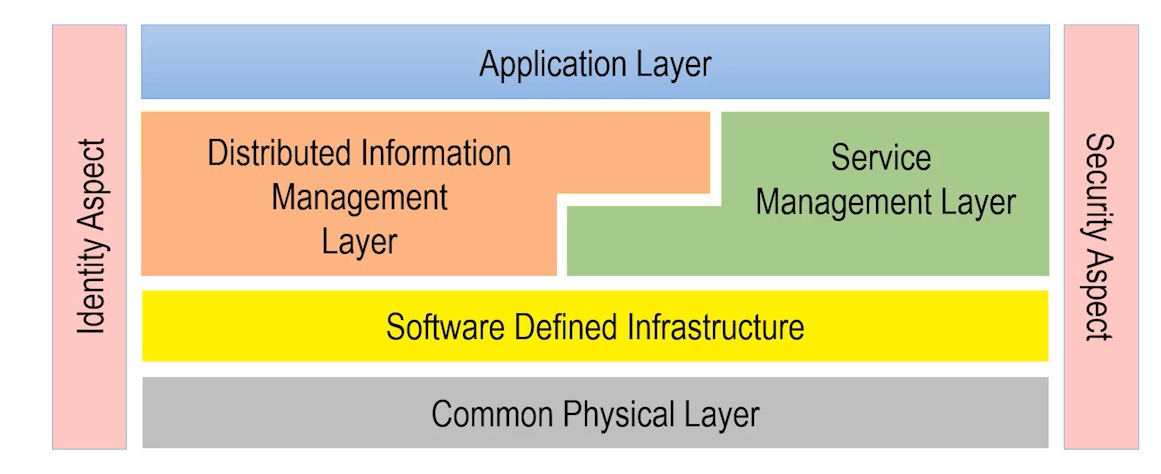

L’Architecture Edgemere

L’architecture Edgemere fournit un modèle pour mettre en œuvre la sécurité à travers des piles technologiques modernes complexes couvrant le matériel, la virtualisation, le cloud, les données et les applications. L’application de principes de confiance zéro de manière holistique à travers ces couches est essentielle pour la gestion des risques. Des capacités robustes de cybersécurité telles que le cryptage et les contrôles d’accès sont essentielles pour apporter de la valeur commerciale à partir de données dans la nouvelle ère de systèmes hautement distribués et interconnectés.